SBCFormer: シングルボードコンピュータで動作可能な軽量画像認識モデル

- Post by: admin

- 2025-03-26

- No Comment

近年、ディープラーニングによる画像認識は農業、漁業、畜産などの実世界の応用に広がりつつある。これらの応用では、高速な処理よりも低コスト・低消費電力なシステムが求められ、シングルボードコンピュータ(SBC)上での実行が重要となる。しかし、これまでに提案されてきた軽量ニューラルネットワークの多くは、スマートフォンを想定した設計であり、Raspberry Piのような低スペックCPUでは性能や速度の点で限界があった。

本研究では、そうした制約のもとでも高精度な画像認識を可能にする軽量モデル「SBCFormer」を提案する。これはCNNとVision Transformer(ViT)のハイブリッド型アーキテクチャであり、低消費電力かつ限定的な計算資源しか持たないSBC上での推論を前提として設計されている。

技術的課題と設計方針

Transformerの自己注意(self-attention)機構は、CNNに比べてハードウェア的に単純なメモリアクセスパターンで動作するため、並列性やバンド幅が限られるCPU環境において有利である。一方で、self-attentionはトークン数の二乗に比例して計算量が増大するため、高解像度画像や大きな特徴マップに適用すると非常に非効率になる。

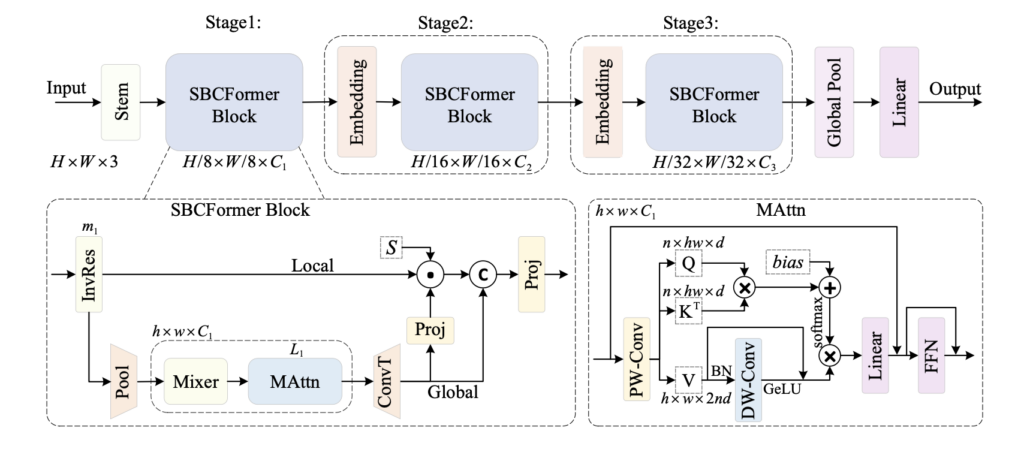

そこでSBCFormerでは、self-attentionを計算負荷の低い小さな特徴マップに限定的に適用し、失われる局所情報を補完するための工夫として「二重ストリーム構造(local stream と global stream)」を導入している。

二重ストリーム構造と注意機構の改良

SBCFormerの各ブロックは、まず入力特徴マップに対してMobileNetV2由来のInverted Residual Block(InvRes)を適用し、初期処理を行う。その後、特徴マップは2つの流れに分岐する。

- Global Stream:特徴マップを一度7×7サイズまで平均プーリングで縮小し、self-attentionとInvResを適用した後にアップサンプリングを行う。これにより、全体的な文脈情報を低コストで抽出する。

- Local Stream:元の解像度を保ったまま特徴マップを通過させ、細部の情報を維持する。

最終的に、global streamの出力を用いてlocal streamの特徴マップに重み付けを行い、両者をチャネル方向に結合する。この構造により、局所情報と大域的情報の両方を保持した高表現力な特徴マップが得られる。

また、self-attentionの表現力向上のために、Value成分に対してDepth-wise Convolution、GeLU、Batch Normalizationを加えた構造を導入し、学習性と表現力を補っている。

評価実験と成果

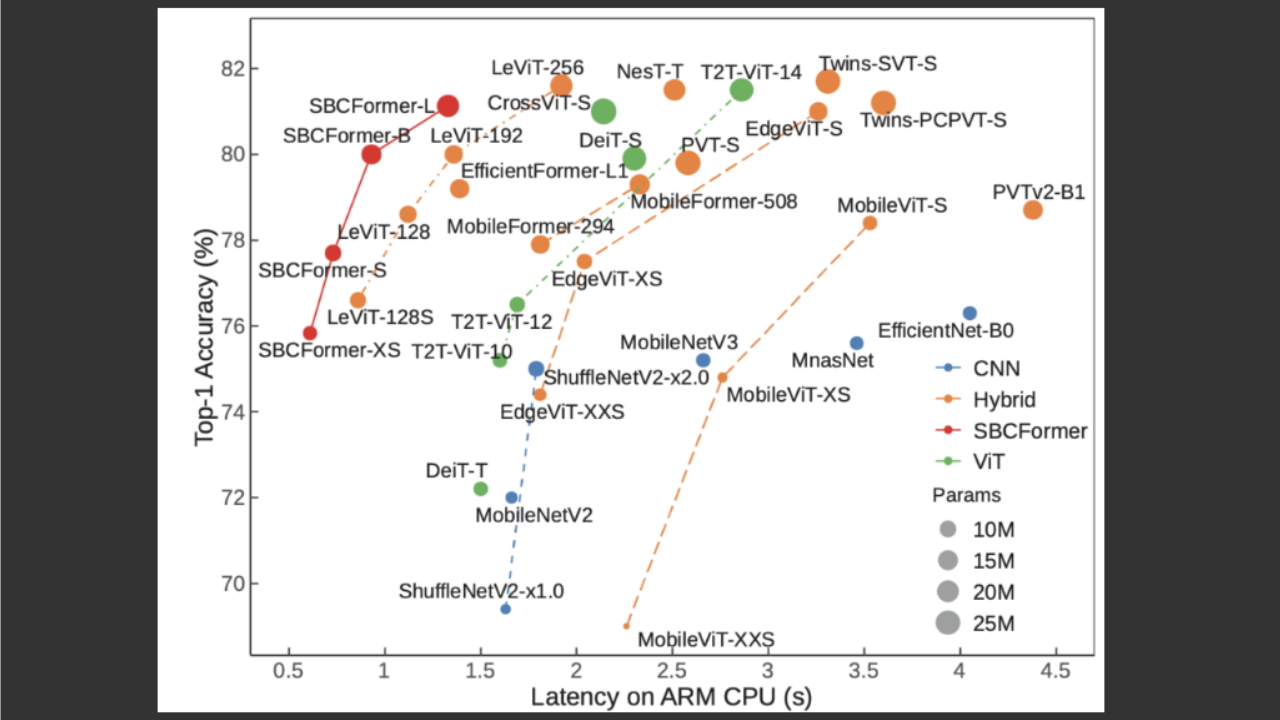

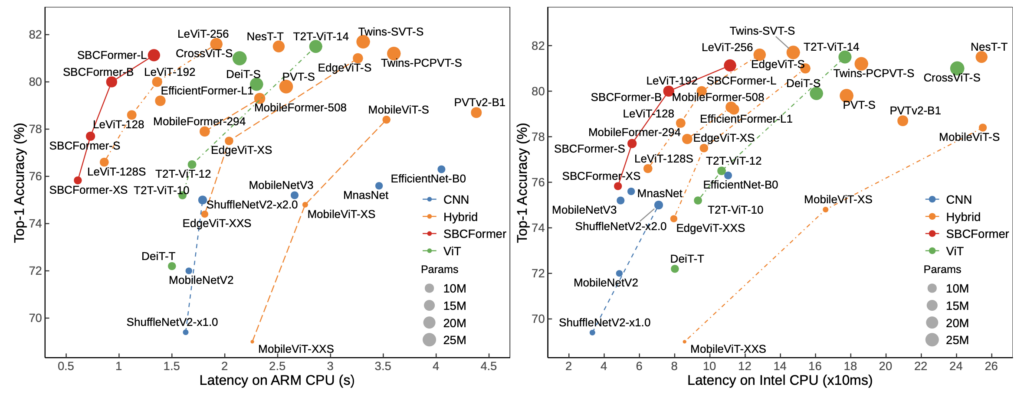

SBCFormerは、画像分類タスクとしてImageNet-1Kを用いて評価された。特にRaspberry Pi 4(ARM Cortex-A72搭載)上での速度・精度のトレードオフに注目した。

その結果、SBCFormer-Bは、ImageNet-1Kにおいて80%のTop-1精度を達成しつつ、推論速度は1.0フレーム/秒を実現した。これは、既存の軽量CNN(MobileNetV2/V3、EfficientNet)やハイブリッドモデル(EdgeViT、MobileViTなど)と比較しても、特にCPU上での性能において優れた結果である。

また、構成要素の有効性を確認するためのアブレーション実験により、local streamおよび改良型attentionの両方が精度向上に寄与していることが明らかとなった。

さらに、COCOデータセットを用いた物体検出タスク(RetinaNet)においても、SBCFormerは同等パラメータ規模の他モデルよりも高い検出精度を示し、画像分類以外の応用にも有効であることが示唆された。

結論と今後の展望

SBCFormerは、低消費電力・低計算資源のデバイス環境において、Transformerの特性を活かしながら、精度と速度のバランスを高い次元で両立したモデルである。特に、限られた計算資源しか持たないエッジデバイスでの実用を想定した設計という点において、新規性と実用性の双方を持ち合わせている。

ただし、評価は特定のハードウェア(Raspberry Pi 4やIntel CPU)に限定されており、他のプラットフォームでは再現性に注意が必要である。また、実運用時の最適化や推論環境の違いによる性能差にも留意が求められる。

今後は、さらなる軽量化や多様なエッジ環境への適応、異なるタスクへの拡張が期待される。

発表論文

Lu, Xiangyong, Masanori Suganuma, and Takayuki Okatani. “Sbcformer: lightweight network capable of full-size imagenet classification at 1 fps on single board computers.” Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. 2024.

@inproceedings{lu2024sbcformer,

title={Sbcformer: lightweight network capable of full-size imagenet classification at 1 fps on single board computers},

author={Lu, Xiangyong and Suganuma, Masanori and Okatani, Takayuki},

booktitle={Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision},

pages={1123--1133},

year={2024}

}