セマンティックセグメンテーションのためのドメイン適応

- Post by: admin

- 2025-03-27

- No Comment

本論文は,セマンティックセグメンテーションにおける教師なしドメイン適応(UDA)の精度向上を目的として,新たな手法「クロスリージョン適応(CRA)」を提案している。セマンティックセグメンテーションは画像内の各画素に意味的ラベルを付与する重要なタスクであり,高精度な学習には大量の注釈付きデータが必要となる。しかし,実世界の画像には注釈付けが困難な場合が多く,合成画像で学習したモデルを実画像へ適用すると分布のずれ(ドメインシフト)が生じる。この問題を解決するために,従来は対向学習による全体的な特徴分布の整合化や自己学習による擬似ラベル活用が試みられてきたが,クラスレベルでのずれが残り,最終的な精度に限界があった。

関連研究

従来のUDA手法は,ソース領域(注釈付きデータ)とターゲット領域(注釈なしデータ)間で特徴分布を整合させることを目的としており,主に対向学習(Adversarial Training)と自己学習(Self-training)の二方向からアプローチしている。対向学習では,ドメイン識別器を用いて両領域の特徴が区別できなくなるように学習するが,クラス毎の細かなずれが残る問題がある。一方,自己学習は,ソース領域で学習したモデルがターゲット領域に対して擬似ラベルを生成し,そのラベルを用いて再学習する手法であるが,擬似ラベルの不正確さが性能低下を招く可能性があった。

提案手法

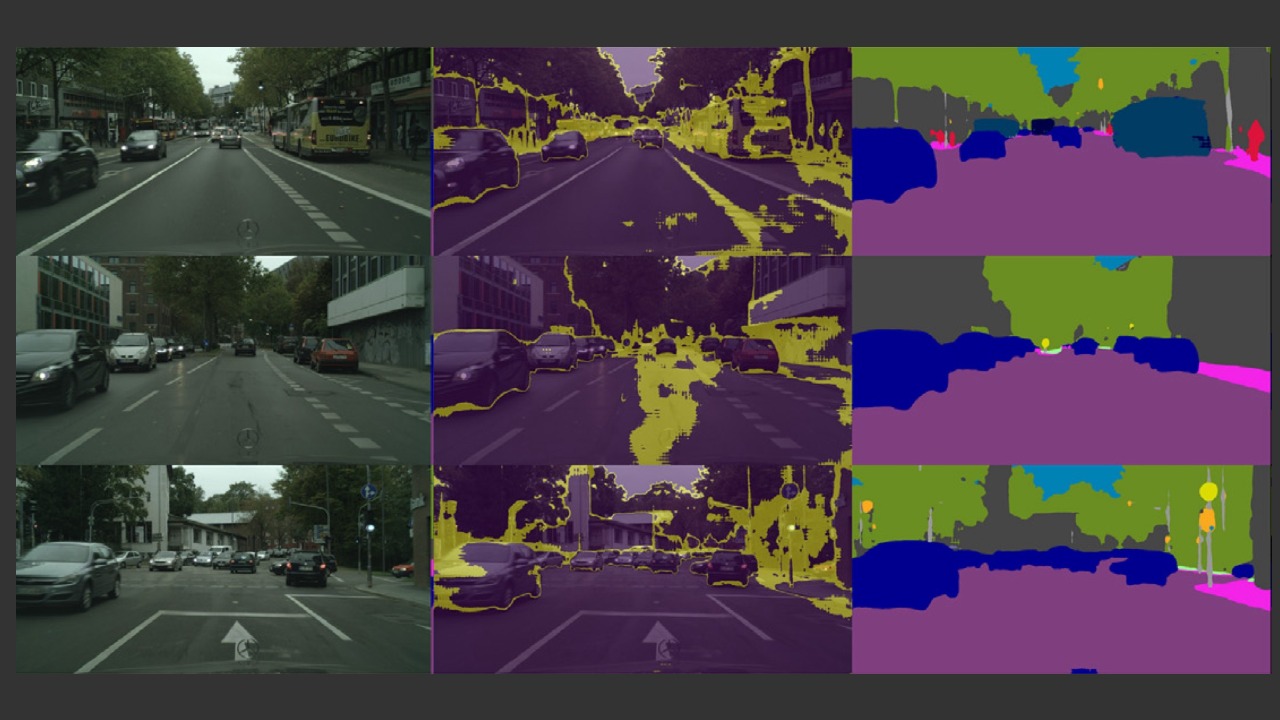

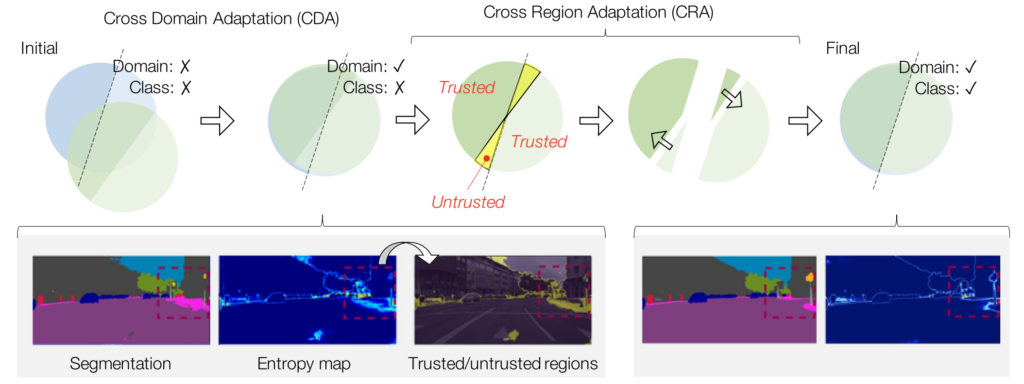

本研究で提案されるCRAは,これらの手法の短所を補完するため,ターゲット領域内でのクラスレベルのミスマッチに焦点を当てた。具体的には,まず既存のUDA手法により得られたセグメンテーションモデルを用いて,ターゲット画像に対して各画素の出力確率からエントロピーを計算し,高い不確実性を示す領域(untrusted)と信頼できる領域(trusted)に分割する。信頼できる領域は,擬似ラベルを用いた自己学習により正しいラベルが得られていると仮定される。一方,不確実な領域は誤分類の可能性があるため,これら二つの領域間で対向学習を行い,特徴空間上での整合を図る。これにより,不正確な分類結果を正しいクラス境界側へ再配置する効果が期待され,最終的なセグメンテーション精度が向上することが示されている。

実験結果

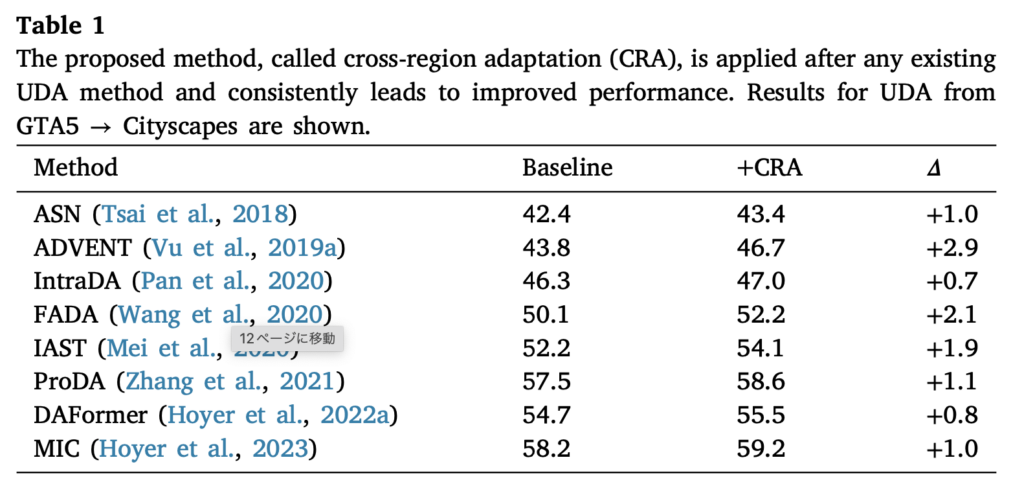

提案手法は,GTA5やSYNTHIA,Synscapesといった合成画像データセットからCityscapesという実世界データセットへのドメイン適応問題に対して評価され,既存のUDA手法に対して一貫して性能改善をもたらすことが確認された。さらに,バックボーンとして用いるネットワーク(VGG16やResNet101,さらにはTransformerベースのDAFormerなど)によっても,CRAの有効性が示され,各手法との組み合わせで平均IoUが向上する結果が得られた。また,エントロピー閾値の設定や希少クラスに対する調整などの詳細な解析,および特徴空間の可視化実験を通じて,信頼領域と不確実領域の整合がセグメンテーション精度の向上に寄与していることが明らかになっている。

まとめ

本論文は,教師なしドメイン適応におけるクラスレベルのミスマッチという課題に対し,ターゲット領域内で画像を信頼領域と不確実領域に分割し,それぞれの特徴分布を対向学習により整合させるCRAを提案した。実験結果から,既存のUDA手法との組み合わせで確実な性能向上が得られることが示され,セマンティックセグメンテーションの精度向上に有用なアプローチとして評価される。本手法は,今後のネットワークアーキテクチャや学習戦略との組み合わせによって,さらなる改善が期待されるとともに,実世界の応用における注釈なしデータの活用可能性を広げる貢献を果たしている。

発表論文

Wang, Zhijie, et al. “Unsupervised domain adaptation for semantic segmentation via cross-region alignment.” Computer Vision and Image Understanding 234 (2023): 103743.

@article{wang2023unsupervised,

title={Unsupervised domain adaptation for semantic segmentation via cross-region alignment},

author={Wang, Zhijie and Liu, Xing and Suganuma, Masanori and Okatani, Takayuki},

journal={Computer Vision and Image Understanding},

volume={234},

pages={103743},

year={2023},

publisher={Elsevier}

}